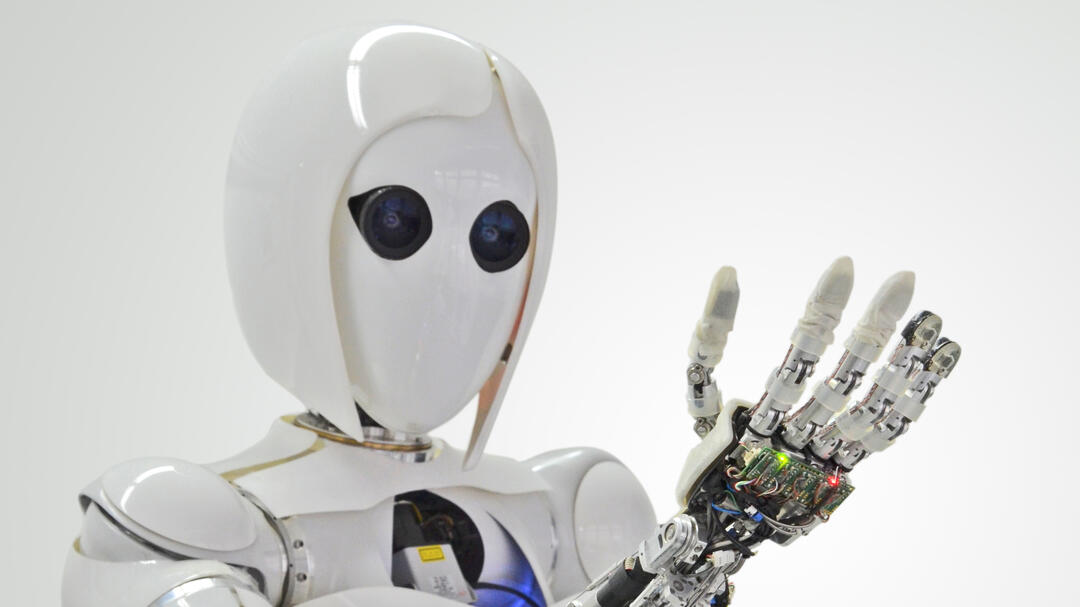

Wie zwei dressierte Schlangen weichen die auf einem Kasten festgeschraubten Roboterarme den Händen des Mannes aus. Nicht nur ihre Greifzangen halten einen Sicherheitsabstand zum Menschen – der gesamte in sich sehr bewegliche maschinelle Arm ist dazu in der Lage. Die Gelenke des Robotersystems sind rund, Ecken und Kanten fehlen. Diese Maschine bewegt ihre Montagearme erstaunlich fließend, fast elegant. Das System reagiert auch auf Gesten: Als der Mann seinen Arm senkrecht in die Höhe hebt, erkennt der Roboter den Befehl und erstarrt zu Stein. (Die Funktionsweise des Roboters im Video.)

Bislang sind Maschinen nicht schlau genug, um direkt neben dem Menschen zu montieren, zu schweißen und zu lackieren. Robotersysteme arbeiten weitestgehend noch hinter Schutzgittern, damit sie Arbeiter nicht verletzen. Anders das oben beschriebene Robotersystem iMRK: Es demonstriert eindrücklich, wie eine intelligente Mensch-Roboter-Kollaboration im Zeitalter von Industrie 4.0 wohl aussehen wird. Schutzgitter sind dann überflüssig. Und die Roboter werden, wie es Wolfgang Wahlster, Informatikprofessor und CEO des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI) gerne formuliert, aus ihren Käfigen befreit.

iMRK ist ein gemeinsamer Innovationsvorstoß des Robotics Innovation Centers (RIC) der DFKI GmbH und des Smart Production Labs der Volkswagen AG. Das Projekt erforscht eine kollisionsfreie Dual-Arm-Manipulation in einem geteilten Mensch-Roboter-Arbeitsraum. Es geht um die Entwicklung der hierfür notwendigen Hard- und Software. Zugleich aber um eine Zeitenwende: Intelligente, autonome Maschinen sind in der Gesellschaft umstritten.

Innovationssystem

Roboter mit Gefühl

Werden Maschinen die Menschen ersetzen?

„Die meisten Menschen rufen ja nicht gerade ‚Juhu‘, wenn über Automatisierung, Industrie 4.0 oder den Pflegeroboter, der der Oma die Hand tätscheln soll, geredet wird. Es gibt Skepsis, es gibt Ängste, vor allem auch vor dem Ersetztwerden“, erklärt Martina Mara, Roboterpsychologin am Ars Electronica Futurelab in Linz. Die wichtigsten Fragen seien daher: Wie kann man Roboter gestalten und einsetzen, ohne dass sich Menschen durch die Technologie dominiert fühlen oder sie als Bedrohung erleben?

Damit beschäftigte sich auch das vom Stifterverband mit initiierte Hightech-Forum, das die Bundesregierung von 2015 bis zum Ende der aktuellen Legislaturperiode 2017 in Innovationsfragen berät. Ein von acatech (Deutsche Akademie der Technikwissenschaften) koordiniertes Fachforum des Hightech-Forums erarbeitete speziell Handlungsempfehlungen zum Thema Autonome Systeme und zog folgendes Fazit: Gesellschaftliche und ethische Fragen zu autonomen Systemen sollten nicht abstrakt, sondern entlang der konkreten Technologieentwicklung formuliert und beantwortet werden.

„Die Autonomie der Systeme muss der Autonomie der Menschen untergeordnet bleiben.“

Roboter – unheimliche Helfer?

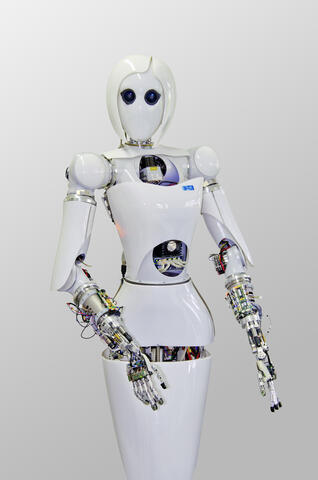

Was Silikongesicht und Kunsthaar angeht: Es ist lange bekannt, dass Maschinen, die beinahe realistisch menschlich aussehen, häufig uncanny wirken – also unheimlich. „Damit haben sich sogar schon Ernst Jentsch und Sigmund Freud im frühen 20. Jahrhundert beschäftigt“, erzählt Roboterpsychologin Martina Mara.

Gerade Androide wirken auf Menschen immer dann unheimlich, wenn sie auf den ersten Blick täuschend echt und lebendig aussehen, auf den zweiten Blick dann aber merkwürdig – ein Gruseleffekt, der in die Kategorie fällt: nachts alleine durchs Wachsfigurenkabinett gehen und plötzlich bewegt sich ein Schatten. Wenn der Mensch etwas nicht klar einordnen kann in Mensch oder Nichtmensch, löst das warnende Gefühle, Ablehnung – und selbst Ekel aus. Der Gedanke an Tote oder Zombies liegt nahe.

Reinhard Karger, Unternehmenssprecher des DFKI, gibt ein Beispiel: „Solche wie Menschen aussehende Roboter, wie sie Hanson Robotics mit Albert Einstein oder Sophia produziert, mögen auf den ersten Blick faszinieren. Wenn man sich ihnen aber zuwendet, sie genauer anschaut, fühlt man sich getäuscht und die erste Sympathie sackt ziemlich schnell in den Keller.“ Der sogenannte Uncanny-Valley-Effekt tritt ein. Karger beschreibt ihn so: Das künstliche Gegenüber sei entweder offensichtlich nicht menschlich oder aber ununterscheidbar von einem Menschen – in beiden Situationen reagierten Menschen im Wesentlichen positiv. Ganz anders bei einer schlechten „Kopie“, die menschenähnlich sein soll, es aber erkennbar nicht ist: Hier reagierten Menschen mit Ablehnung. Und Menschen würden Imitate außerordentlich gut erkennen, so Karger.

Werkzeuge ohne menschliche Persönlichkeit

Sollten humanoide Pflegeroboter also besser wie C-3PO aus Star Wars aussehen? Das würde helfen, allerdings kann auch das Verhalten des Roboters, die Software, einen Ablehnungseffekt à la Uncanny Valley auslösen – eine Erkenntnis, die relativ neu ist. Untersuchungen von Martina Mara und Medienpsychologe Markus Appel deuten darauf hin. Mara nennt Details: „Maschinen, die autonom Entscheidungen treffen, und noch stärker solche, die offenbar so etwas wie menschliche Persönlichkeit besitzen, unabhängig von ihrem Äußeren, werden ebenfalls als gruselig wahrgenommen.“ Und das werde Gesellschaft und Wissenschaft sicher noch länger beschäftigen.

Was die Studie verdeutlicht: Selbst da, wo ein gefühlvoller Umgang und Empathie nötig sind, wie beispielsweise in der Pflege, würden sich mitfühlende Maschinen – wenn es sie schon gäbe – auf sehr dünnem Eis bewegen. Der Mensch kommt bislang nur mit Servicerobotern klar, die wie ein Werkzeug funktionieren. „Das Auto fährt, das Smartphone verschickt Nachrichten – so ist Technologie seit Jahrzehnten in den Köpfen abgespeichert“, sagt Markus Appel, Leiter des Arbeitsbereichs Medienkommunikation am Institut Mensch-Computer-Medien an der Universität Würzburg.

Bleibt die Frage: Wollen Menschen überhaupt empathische Technologien haben? Was wünschen sie sich konkret für das Jahr 2053? Und wie kann man das überhaupt herausfinden? Forscher suchten einen Weg und fanden ihn im Rahmen des vom Bundesministerium für Bildung und Forschung (BMBF) geförderten Projekts Shaping Future, das am Fraunhofer Center for Responsible Research and Innovation CeRRI des Fraunhofer-Instituts für Arbeitswirtschaft und Organisation IAO (Fraunhofer IAO) angesiedelt ist. „Unser interdisziplinäres Projektteam entwickelte ein Vorgehensmodell, mit dem Bürger nicht nur ihre Ansprüche an Zukunftstechnologien herausfinden und beschreiben können, sondern auch mit Wissenschaftlern teilen“, so Marie Heidingsfelder, wissenschaftliche Mitarbeiterin am Fraunhofer IAO und verantwortlich für Shaping Future.

Kern des Projekts waren Bürgerworkshops, in denen die Teilnehmenden mithilfe von Designmethoden wie Storytelling und narratives Prototyping konkrete Lösungen für Zukunftsszenarien im Jahr 2053 entwickelten, die ihnen wichtig sind. Die Ergebnisse dieser Workshops wurden sozialwissenschaftlich analysiert und zu „Bedarfsfeldern“ geclustert.

Ein Thema, das in den Workshops hitzig diskutiert wurde, war tatsächlich digitale Empathie. Marie Heidingsfelder: „Es ging darum, wie Technik den Menschen empathischer machen kann. Aber auch, wie smarte Technologie zukünftig empathisch auf Menschen reagieren sollte.“ Eine Idee sei beispielsweise eine Brille gewesen, die dem Träger anzeigt, in welcher emotionalen Verfassung sein Gegenüber gerade ist. „Unsere Welt wird immer komplexer, weshalb sich viele Teilnehmer eine Art Big Mother an ihrer Seite gut vorstellen konnten, die ihnen bei den geistigen und körperlichen Anforderungen des Alltags hilft“, so Heidingsfelder.

Eines habe Shaping Future deutlich gezeigt, so die Wissenschaftlerin: „Dass die Antworten auf die Fragen, ob es empathische oder menschenähnliche Technologie geben sollte oder nicht, so divers sind wie die Personen, die sie geben.“